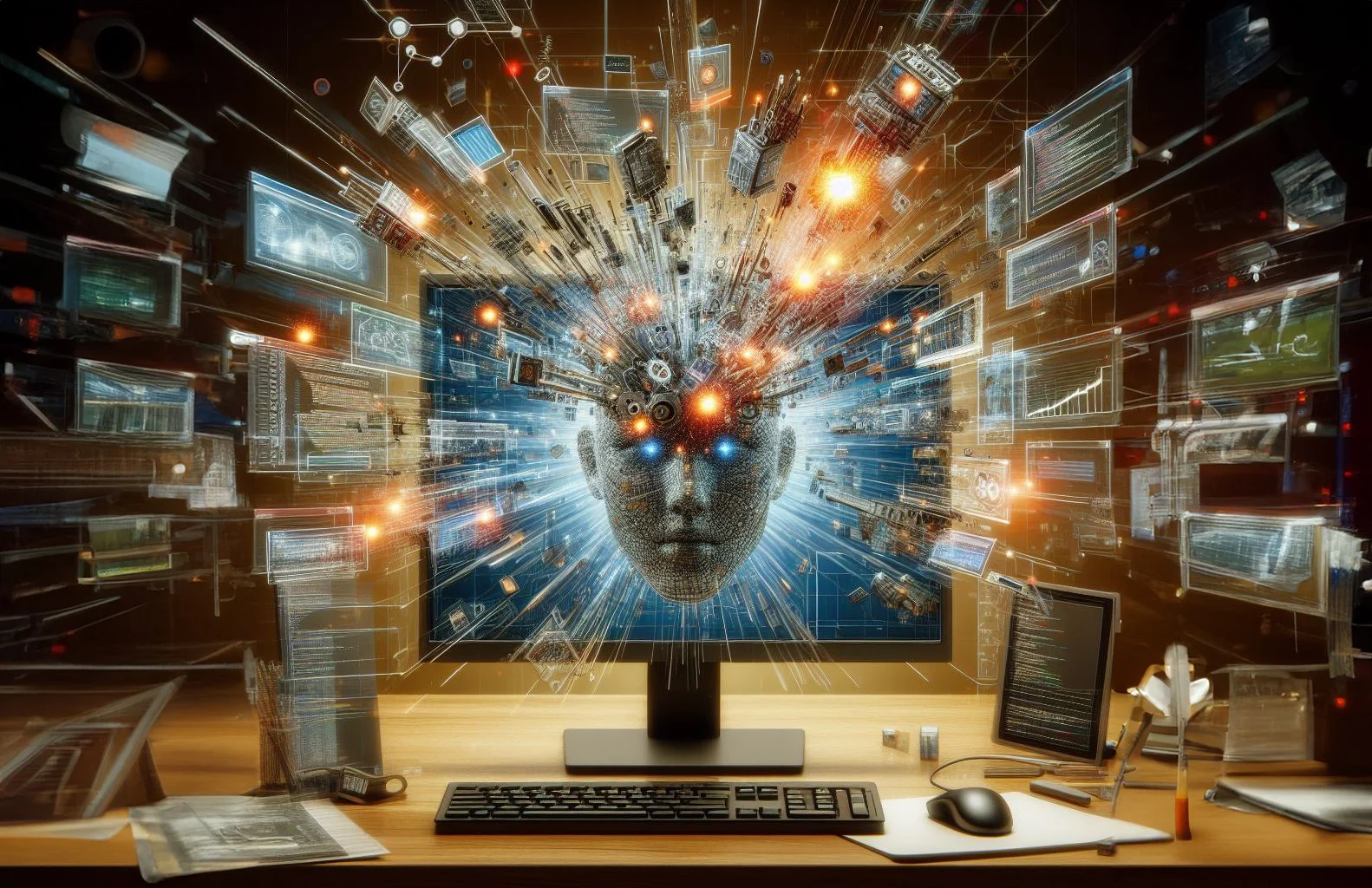

AI this, AI that, AI everywhere... Nhưng để có được một AI đúng nghĩa của riêng mỗi người thì câu chuyện hãy còn xa xăm... Kể từ năm 2024 này, bạn có lẽ chẳng còn gì xa lạ với AI (trí tuệ nhân tạo), cả từ hình thức cơ bản nhất như tự động hoá công việc cho tới tự sáng tạo nội dung và xa hơn là AI đa/toàn năng (AGI - Artificial General Intelligence)... AI không còn là chuyện viễn tưởng như các bộ phim của thế kỷ trước mà đã len lỏi vào rất nhiều ngóc ngách trong đời sống số của chúng ta. Nhưng dù vậy, để gọi là có được một AI đúng nghĩa cá nhân (local AI) nhất là trên PC thì mọi thứ vẫn khá mờ nhạt.

Trước hết, cần xác định rõ hơn định nghĩa AI cá nhân là gì. Thực sự mà nói, đây là vấn đề không có cơ sở ràng buộc chặt chẽ mà sẽ tuỳ thuộc "mức" OCD (khó tính) của từng người như thế nào. Nếu "dễ dãi", bạn có thể xem con Copilot của Microsoft (MS) là một AI cá nhân cũng được, hoặc Google (GG) Gemini hoặc ChatGPT, miễn là bạn có thể giao tiếp và làm việc trực tiếp được với chúng. Nhưng nếu là "người già khó tính", những con bot dựa vô điện toán đám mây (cloud) sẽ không thoả mãn tiêu chí "cá nhân" vì không có kết nối Internet thì chúng xem như "câm điếc mù". Chắc bạn còn nhớ mỗi khi GG hay Facebook "sập mạng" thì cuộc sống số của chúng ta nháo nhào thế nào chứ?

Chúng ta lệ thuộc vô Internet tới mức nào?

Chút vấn đề tên gọi

Trước hết, cần xác định rõ hơn định nghĩa AI cá nhân là gì. Thực sự mà nói, đây là vấn đề không có cơ sở ràng buộc chặt chẽ mà sẽ tuỳ thuộc "mức" OCD (khó tính) của từng người như thế nào. Nếu "dễ dãi", bạn có thể xem con Copilot của Microsoft (MS) là một AI cá nhân cũng được, hoặc Google (GG) Gemini hoặc ChatGPT, miễn là bạn có thể giao tiếp và làm việc trực tiếp được với chúng. Nhưng nếu là "người già khó tính", những con bot dựa vô điện toán đám mây (cloud) sẽ không thoả mãn tiêu chí "cá nhân" vì không có kết nối Internet thì chúng xem như "câm điếc mù". Chắc bạn còn nhớ mỗi khi GG hay Facebook "sập mạng" thì cuộc sống số của chúng ta nháo nhào thế nào chứ?

Chúng ta lệ thuộc vô Internet tới mức nào?

Theo kiểu OCD thì một AI cá nhân sẽ là một con bot có thể hoạt động độc lập trên PC của bạn mà không cần phải lệ thuộc vào Internet (ở góc độ nào đó nó vẫn có thể dùng Internet để tra cứu thông tin giùm bạn nhưng không phải "sống dựa" vào server của MS, GG hay OpenAI...). Trong phạm vi bài viết này, mình sẽ dùng quan điểm OCD. Bạn có thể đang thắc mắc - tại sao lại phải "khó tính" thế?

Có một số lý do, đầu tiên, khoảng 20 năm trở về trước khi Internet còn chưa phổ biến (nếu là dân 7x, 8x, 9x thì bạn sẽ hiểu), hầu hết mọi ứng dụng PC đều là ứng dụng local. Bản thân các ứng dụng AI lúc đó (chủ yếu là chatbot) cũng thế. Không có "trợ giúp" từ Internet, con bot AI nào "thông minh" hay "ngu ngốc" sẽ hiện rõ mồn một (kiểu đi thi mà không được phép quay bài).

Tiếp nữa, khi tất cả các hãng phần cứng như Intel, AMD, NVIDIA, Qualcomm cùng "nổ" về NPU của họ, làm sao để biết NPU của ai tốt hơn ai khi bạn dùng cloud AI để làm việc? Và cái vấn đề khác nữa - cloud AI không cần PC của bạn phải có NPU thì ý nghĩa trang bị NPU trên chip của bạn có khác gì "làm cảnh"? Bạn gắn hay không gắn con card RTX thì bạn vẫn nói chuyện bình thường với ChatGPT được mà (quan trọng là net phải ngon)?

Bạn không cần phần cứng chuyên dụng để xài cloud AI

Nhưng quan trọng hơn hết (và có lẽ cũng là điều chính yếu cần phân biệt local AI vs. cloud AI) chính là tính bảo mật thông tin. Mình không nói rằng local AI không có rò rỉ thông tin nhưng cloud AI thì chắc chắn thông tin của bạn sẽ luôn nằm trên server của người khác. Và ở 2024 này, trừ phi là người tối cổ hay introvert (hướng nội) tuyệt đối, còn không chắc hẳn bạn đã từng thấy quảng cáo của GG, Facebook (FB) ở đâu đó ngay khi bạn vừa chat hay gọi điện cho bạn bè về một vấn đề gì đấy (miễn là có keyword nằm trong bộ lọc của quảng cáo). Có lẽ chưa khi nào mà tính riêng tư của cá nhân bị vi phạm nghiêm trọng như kỷ nguyên IoT và Big Data (hay Big Money?) này. Không bị sales bất động sản hay bảo hiểm hay chứng khoán hay coin gọi thì cũng là một "cán bụ" nào đó đọc vanh vách tên và thông tin của bạn để đòi chuyển tiền vô tài khoản...

Big data = Big Money

Có một câu nói phổ biến như này về chủ nghĩa tư bản - làm ăn kinh doanh kiếm tiền chứ không phải làm từ thiện. Bất kỳ dịch vụ cloud nào cũng đều tốn tiền đầu tư nghiên cứu, xây dựng và vận hành. Đơn giản nhất là chi phí tiền điện chỉ để nuôi server chạy 24/7/365 và công ty bán điện dĩ nhiên là không bán "free". Thế nên bằng cách này hay cách khác, mọi nhà đầu tư vô cloud đều phải tìm cách kiếm được tiền từ dịch vụ của mình. Ví dụ bạn không muốn làm khách hàng trả tiền cho GG để xem YouTube thì dữ liệu của bạn thành sản phẩm để họ đem đi bán và điều đó sẽ lặp lại với cloud AI. Hoặc bạn mất tiền để hưởng dịch vụ, hoặc bạn bị "đem bán", thậm chí là cả hai!

Big data có nghĩa dữ liệu của bạn là tiền của người khác

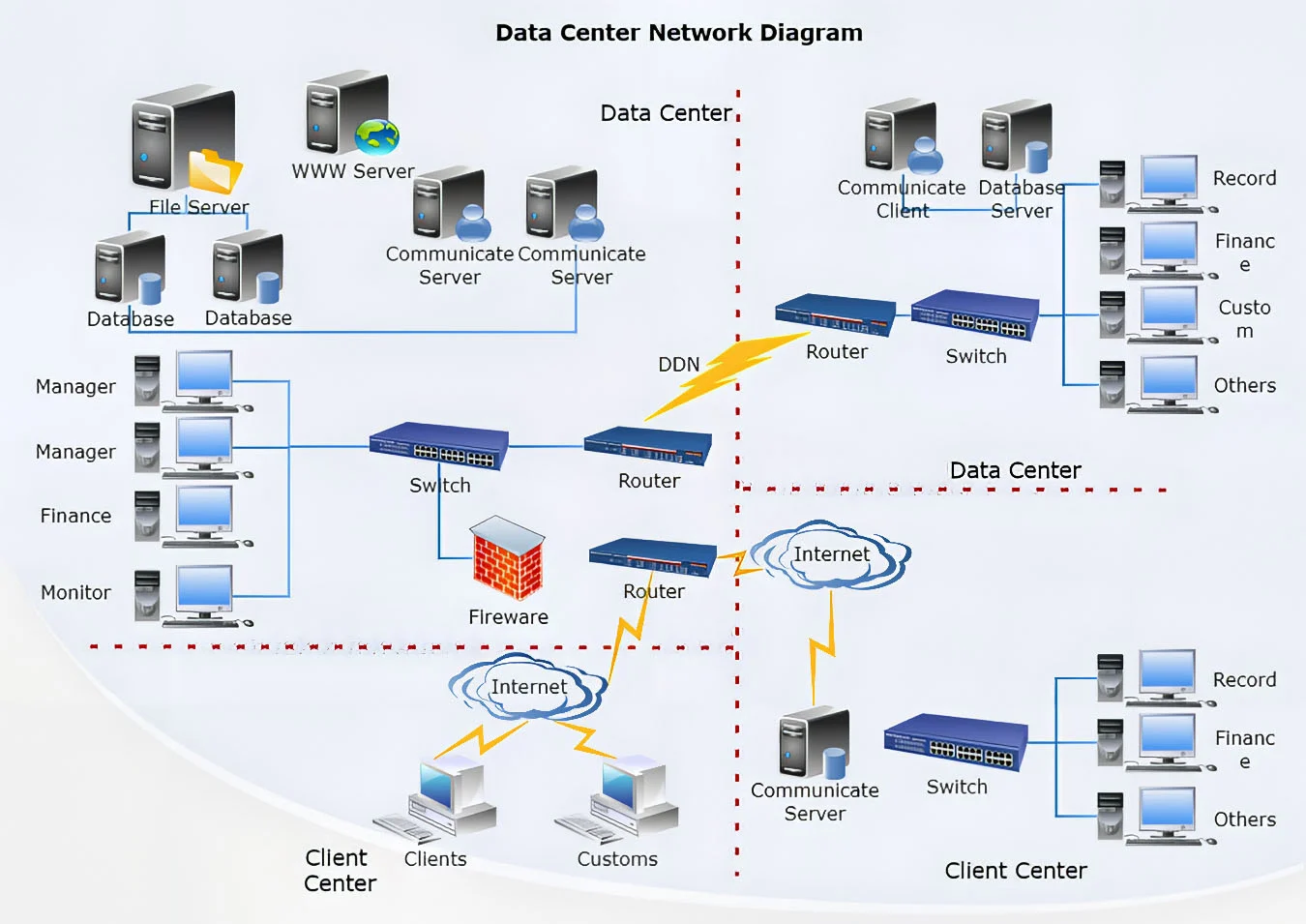

Tất nhiên, dùng local AI không có nghĩa là bạn tuyệt đối an toàn. Những công ty phát triển những ứng dụng AI local vẫn có thể tự ý thu thập data của bạn về server của họ, nhưng bạn có thể dùng tường lửa để hạn chế bớt các rủi ro trên. Ngoài ra, việc có thu thập data hay không và như thế nào còn lệ thuộc mô hình kinh doanh của từng công ty. Những công ty chỉ viết phần mềm kiếm sống thì việc xây dựng datacenter khổng lồ với họ là vô nghĩa vì như đã nói, chi phí vận hành rất tốn kém. Thu thập data mà không làm gì thì chỉ tốn điện với ổ cứng để lưu trữ.

Một chi tiết khác bạn có thể quan tâm là lập trình trong tương lai sẽ dễ hơn hiện tại nhiều (mà hiện tại còn dễ hơn cả quá khứ vài chục năm trước). CEO NVIDIA từng nói trẻ con sắp tới không cần học code nữa vì AI có thể làm được việc đó. Có thể ngay lúc này bạn chưa thể nhờ ChatGPT code ra một con local AI xịn xò được, nhưng 20 năm nữa thì ai biết được. Nhất là nếu mã nguồn mở trong nhà nhà có thể xài thì vấn đề còn thoải mái nữa. Hoặc nếu bạn có "đứa em SN 1996 đang làm coder vua của mọi nghề blah blah blah" thì có thể thuê họ code cho một con AI xài riêng cũng được. Suy cho cùng "software as a service" hay "coding as a service" thì local AI không phải là quá khó.

Xây dựng datacenter cực kỳ tốn kém

Thoạt nghe mọi thứ thật dễ chịu phải không? Nhất là local AI (theo kiểu OCD). Song trước mắt (ít nhất là trong 2024 này), nhiều gam màu về nó vẫn xám xịt chứ chưa được hường cánh sen như tranh vẽ...

Những vấn đề của local AI

Trước tiên và trên hết, AI nói chung hay các NPU nói riêng trên từng con chip vẫn là một tính năng phần cứng mới. Sẽ mất nhiều năm để mọi chiếc PC đều được trang bị NPU giúp hỗ trợ xử lý AI, nên không phải chiếc PC nào cũng đáp ứng đủ điều kiện phần cứng (nếu app bắt buộc phải có NPU) ngay lúc này để chạy được local AI.

Nhưng phần cứng mới là phần nổi của tảng băng. Nếu là dân công nghệ lâu năm, hẳn bạn sẽ biết phần mềm luôn luôn chạy sau phần cứng. Có rất nhiều tính năng công nghệ đã xuất hiện lâu trên phần cứng nhưng mãi về sau phần mềm mới hỗ trợ. Trong vài trường hợp thậm chí, tính năng đó bị "lãng quên" hoặc phạm vi ứng dụng bị bó hẹp. Có thể lấy ví dụ như PhysX của NVIDIA hay AVX-512 của Intel hay 3DNow! của AMD. Tất nhiên AI là thứ đang được toàn ngành công nghiệp hỗ trợ thì nó sẽ có tương lai nhiều hơn những tính năng bị gắn chết với một hãng nào đấy.

Một vấn đề của AI là có quá nhiều công nghệ và mô hình khác nhau

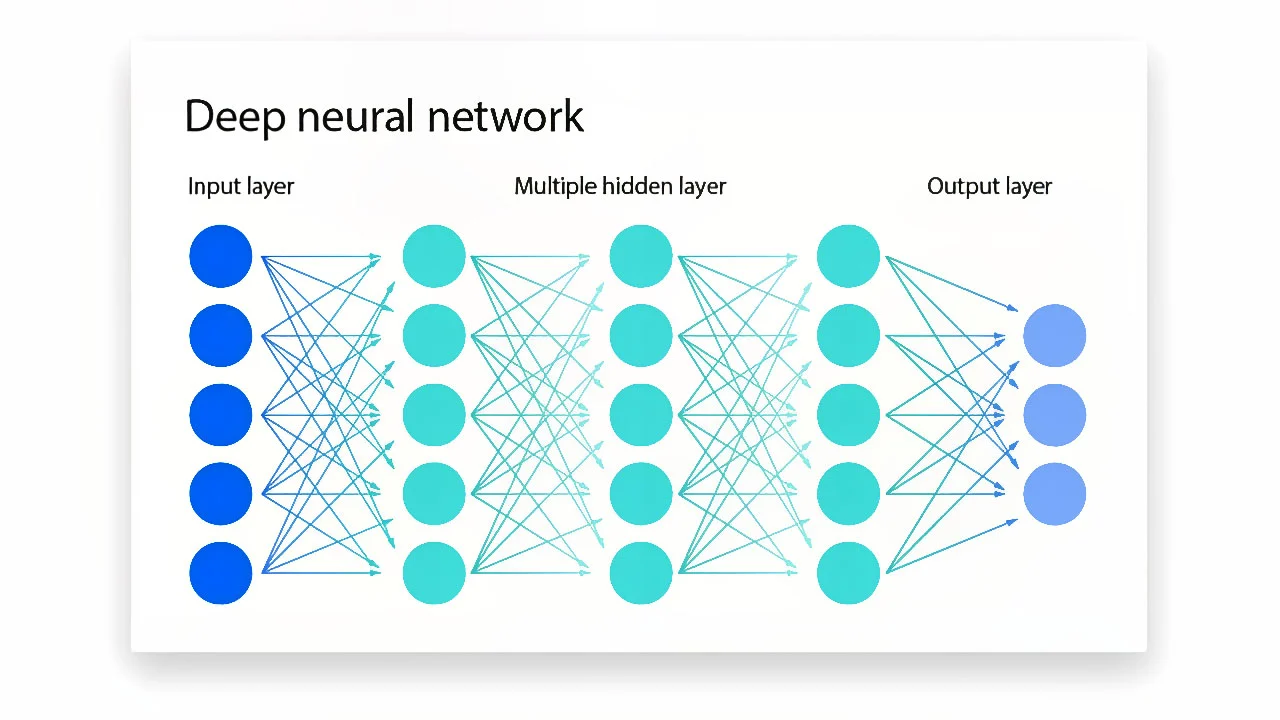

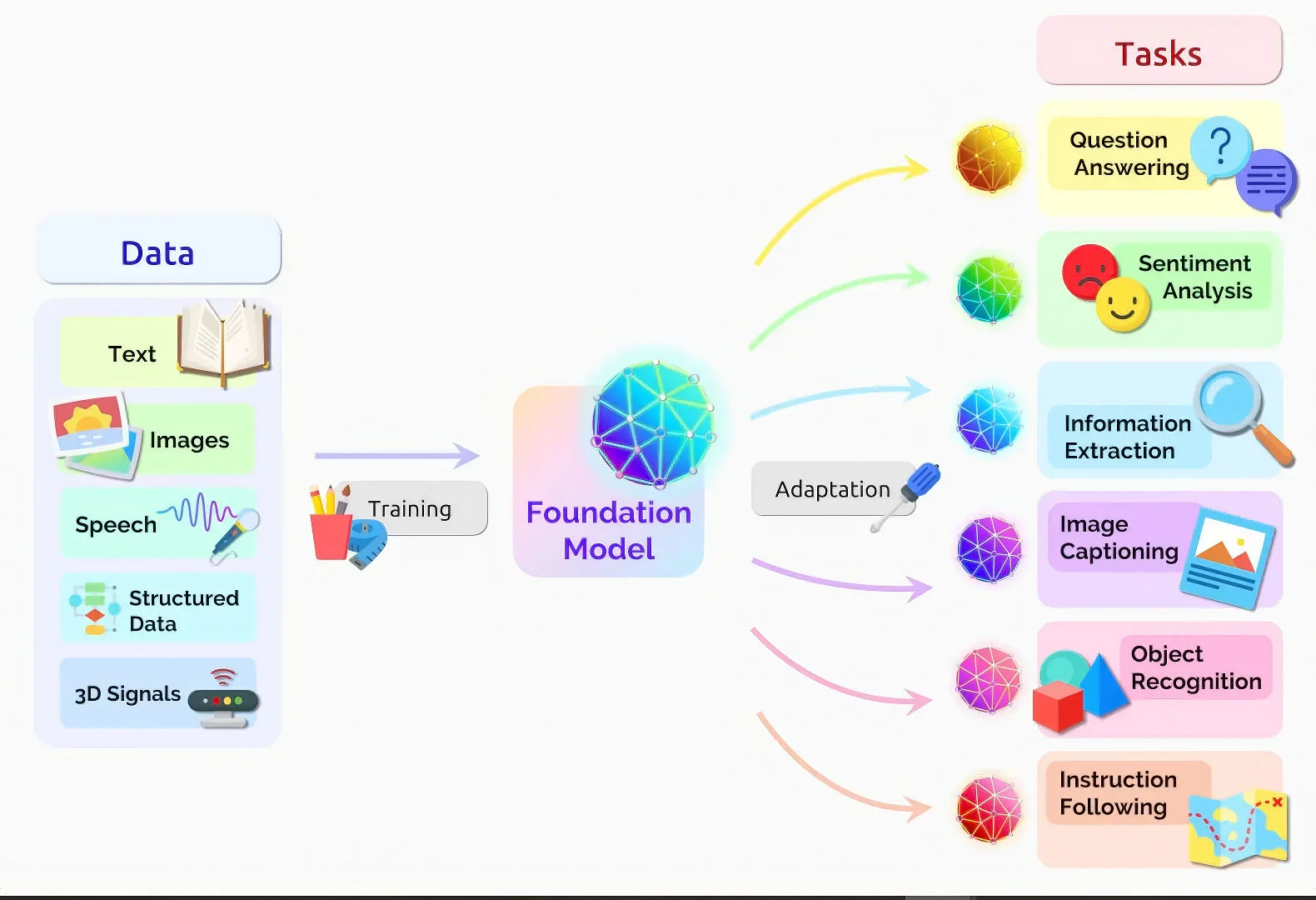

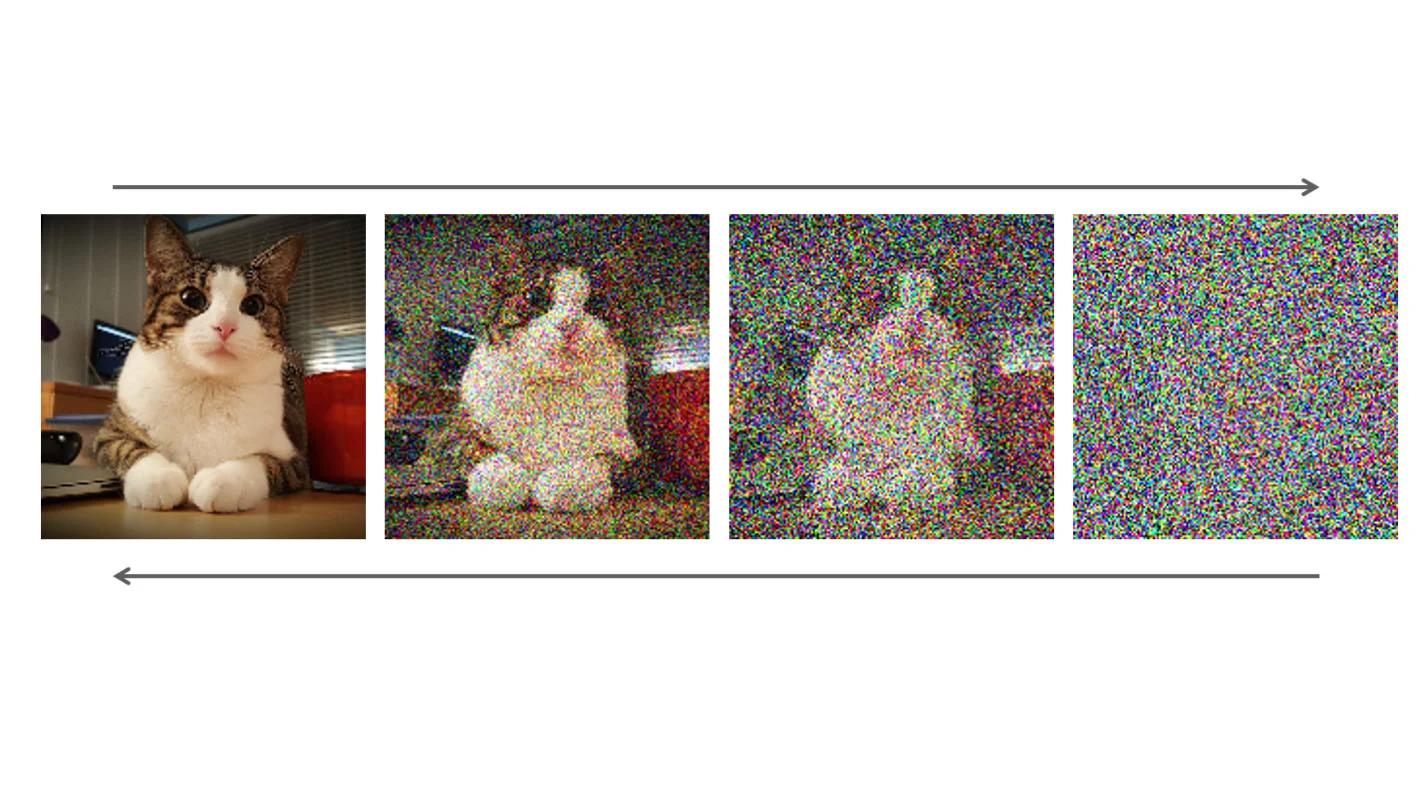

Dù vậy, kể cả khi phần cứng đã sẵn sàng thì việc khai thác chúng cũng không hề đơn giản. Một vấn đề khi nhắc tới AI mà ít ai để ý là hiện đang có rất nhiều hình thức AI khác nhau. Từ cái gốc AI cho tới Học máy (Machine Learning) rồi Học sâu (Deep Learning). Riêng khoản AI sáng tạo nội dung (Generative AI) cũng đã có những mô hình con như Foundation, Multimodal, Large Language (LLM), Diffusion...

Một cách ví von là AI cũng như... ung thư. Ai cũng nghĩ ung thư là một căn bệnh nhưng thực chất, đó là một trạng thái tế bào của một cơ quan bất kỳ - ung thư phổi khác ung thư dạ dày mà cũng chả giống ung thư trực tràng hay ung thư máu. Và AI cũng thế, nó rất rộng và có nhiều cách thức phát triển khác nhau. Kể cả một NPU chuyên biệt cũng không chắc chắn đã chạy được hết mọi ứng dụng AI trên đời. Thế nên để nói về ứng dụng AI thì cần nói rõ hơn là AI nào. Chắc chắn là ChatGPT không thể giống với Stable Diffusion hay AlphaFold.

Những mô hình AI khác nhau hiện nay

Hạn chế sau cùng mà cũng có thể nói là lớn nhất và... không thể khắc phục của local AI chính là nó không phải là cloud AI. Tuy mặt trái của cloud AI là phải có Internet và có rủi ro người dùng bị thông tin, nhưng ngược lại thì chúng ta không phải quan tâm về tất cả những vấn đề khác của local AI. Bạn không cần phải có card RTX hay CPU Core Ultra hay Ryzen AI để làm việc với ChatGPT. Thứ duy nhất bạn cần là một đường truyền Internet cực xịn. Chưa kể local AI không có sẵn database cực lớn như cloud AI để "học". Nên chúng sẽ bị giới hạn về mặt năng lực, trừ phi hãng phát triển thường xuyên cập nhật để chúng không "hụt hơi" với cloud AI.

Trong khi sức mạnh của cloud AI đến từ hệ thống datacenter, thì local AI lại dựa trên phần cứng lẫn phần mềm có sẵn của người dùng. Vậy nên trải nghiệm local AI tốt hay không tốt thực sự không có gì đảm bảo (thậm chí còn phụ thuộc cả năng lực của người dùng). Nhưng cloud AI thì như đã nói, chủ yếu nằm ở đường truyền của bạn xịn tới đâu. Nói theo kiểu "vơ đũa" - cloud AI dành cho tất cả mọi người, local AI dành cho geek (dân chơi công nghệ).

Tạm kết

Dĩ nhiên nói như thế không có nghĩa bạn nên xài cái này hay cái kia. Vì như đã nêu, local hay cloud thì cái nào cũng có 2 mặt, được của bên này thì mất của bên kia và ngược lại. Chủ yếu ở chỗ bạn cần biết nhu cầu của bản thân là gì, những sản phẩm đang có trên thị trường là gì và cái nào hợp với bạn. Có thể trong mảng nghiên cứu thị trường, trending này kia thì việc cập nhật liên tục dữ liệu là cần thiết thì cloud AI sẽ phát huy tốt hơn. Nhưng khi bạn lo ngại những vấn đề bảo mật và bản quyền trí tuệ thì local AI sẽ đảm bảo hơn.

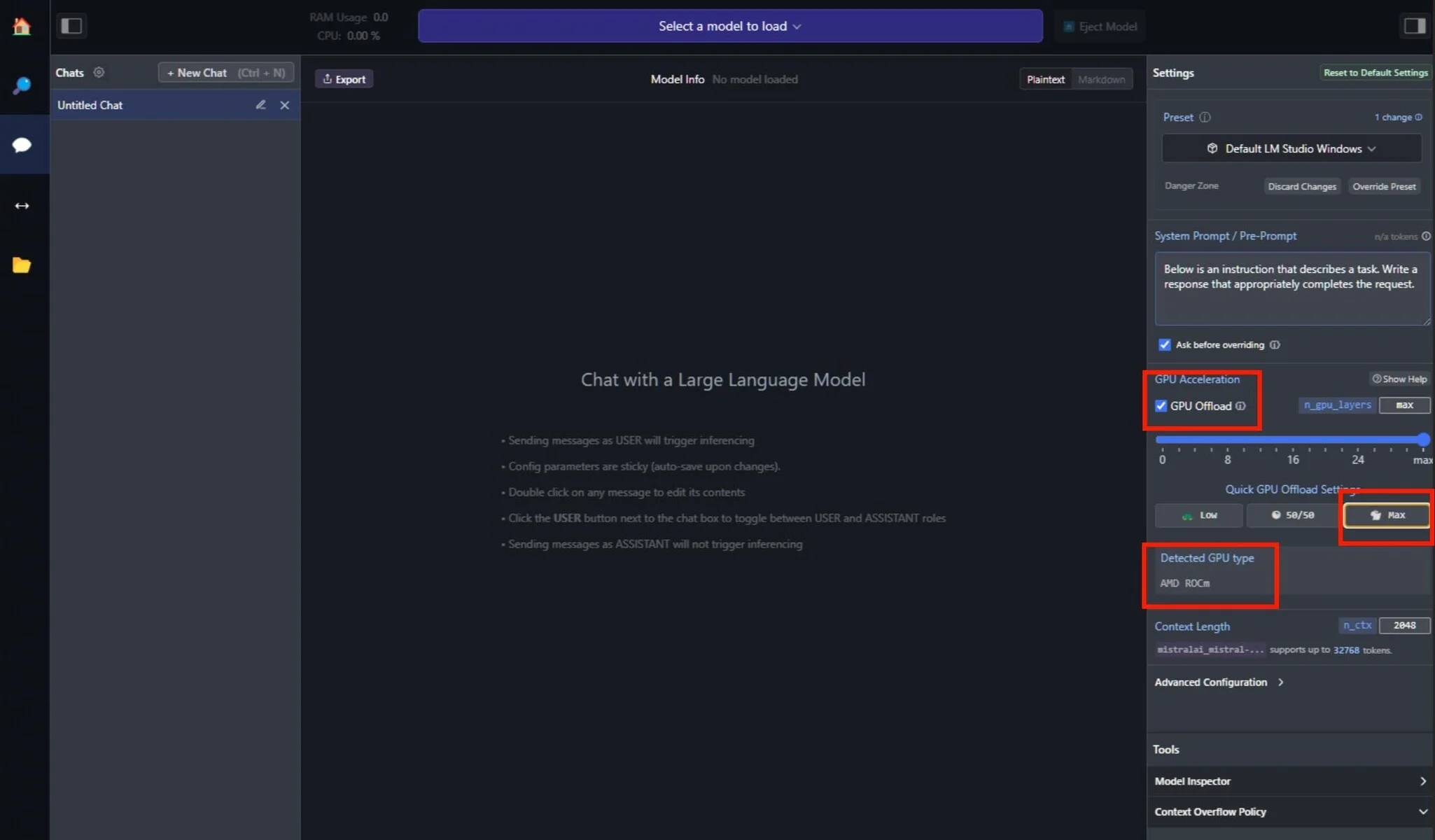

Cài đặt local AI không dễ như nhập yêu cầu vào cloud AI

Nhìn chung, trước mắt trong giai đoạn ngắn hạn, local AI sẽ có rất nhiều vấn đề cần khắc phục. Không chỉ sự phân mảnh của cả phần cứng lẫn phần mềm và mô hình phát triển mà còn là người dùng sẽ "chịu" chạy theo đến đâu. Dù sao trong kỷ nguyên IoT này, việc bỏ tiền ra thuê một dịch vụ cloud nhìn chung vẫn dễ dàng và thoải mái hơn việc chọn một con card hay CPU, cài đặt OS lẫn driver cho phù hợp rồi phải mở app "đúng cách" thì mới trải nghiệm được.

Trước mắt cloud AI vẫn tiện dụng cho tất cả mọi người

Con đường tương lai hãy còn rộng và dài...